2023. 3. 3. 23:31ㆍ딥러닝 이론

오늘 공부한 내용은 Ch. 5-4, 5-5입니다:

- Bernoulli & Gaussian분포 그들의 MLE 어떻게 되나?

- NLL (negative log likelihood)란?

- Softmax를 이용한 다중분류

지금 까지 배운 수학 파트를 드디어 활용하는 인공신경망 속의 MLE을 공부해 보겠습니다. 이번에는 Gaussian, Bernoulli, Multinoulli에 대해서 알아보고 차이다 알아볼 것입니다. Negative log likelihood의 정의도 알아보겠습니다. 마지막으로 Softmax를 배우는 부분에서 cross entropy가 나오는데 그 부분은 내일 공부해 보겠습니다.

1. Bernoulli & Gaussian분포 그들의 MLE어떻게 되나?

Gaussian, 또는 normal 분포는 저번에 공부해봤습니다. Gaussian은 pdf이라서 discrete 하지 않은 데이터에 대한 분포를 가지고 있습니다. Pdf의 적분의 합은 1이고, pmf의 event들의 합이 1입니다. 키와 몸무게는 보통 가우시안 분포로 표현을 많이 하죠. 키와 몸무게는 자연수인 40, 41, 42가 아닌 40.0, 40.1, 40.11111 등으로 표현이 될 수 있기 때문에 pmf가 될 순 없죠.

그럼 이제 Bernoulli에 대해 알아봅시다. Bernoulli distribution은 pmf이고 모든 event가 independent 하다는 조건이 걸려 있습니다. 6면 주사기를 던지는 것 과 같은 상황이죠.

2. NLL (negative log likelihood)란?

Likelihood -> Log-likelihood -> NLL이 과정을 보면서 이해해 보시길 바랍니다.

Likelihood

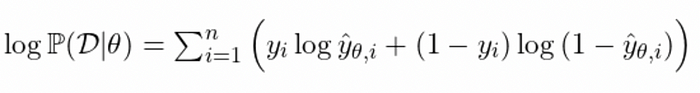

Log-likehood

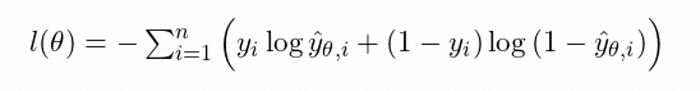

Negative log likelihood

3. Softmax를 이용한 다중분류 (multiclass classification)

자 이제 binary classification문제의 구조를 짤 수 있지만 multi-class 즉 2 이상인 상황은 어떻게 해야 하나요?

이때 쓰이는 게 softmax입니다. 여기서 주의해야 하는 부분은 multi class classification vs. multi label classification입니다.

Multi class는 one-hot encoding을 사용해 한 category에 대해서만 True가 있을 수 있다. 그래서 이 사진에는 '고양이'가 있다/없다에 대해 모든 category에서 하나만 1일 수 있다. 하지만 multi label은 한 사진에 '고양이' '강아지' '쥐'가 다 있으면 모든 해당되는 label에 전부 1을 표기해야 한다.

이를 구축할 때에:

- multi class -> softmax

- multi label -> category_size마다 sigmoid 하면 되겠습니다.

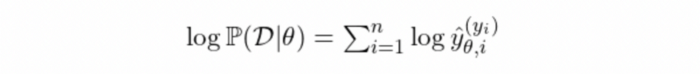

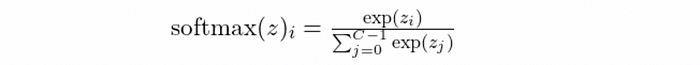

이제 다시 softmax에 대해 공부해 봅시다. 일단 multinoulli distribution 기반이고 이 분포의 log likelihood는 이렇습니다:

전에 했던 수학 과정을 똑같이 이 log likelihood에 적용하면 우리는 softmax함수의 정의를 할 수 있다:

강의 내용이 어려워 복습하는 데로 업데이트를 하겠습니다.

참고:

https://towardsdatascience.com/cross-entropy-negative-log-likelihood-and-all-that-jazz-47a95bd2e81

Cross-Entropy, Negative Log-Likelihood, and All That Jazz

Two closely related mathematical formulations widely used in data science, and notes on their implementations in PyTorch

towardsdatascience.com

https://bjlkeng.github.io/posts/probabilistic-interpretation-of-regularization/

A Probabilistic Interpretation of Regularization

A look at regularization through the lens of probability.

bjlkeng.github.io

'딥러닝 이론' 카테고리의 다른 글

| Day 14: Chapter 6-1, 6-2 Universal Approximation Theorem (0) | 2023.03.05 |

|---|---|

| Day 13: Ch.1-21 정보 이론 기초 (마지작 수학 파트) (0) | 2023.03.04 |

| Day 11: Chapter 1-20 MAP, MLE vs. MAP비교 (0) | 2023.03.02 |

| Day 10: Chapter 1-19 MLE (최대 우도 추정)에 대해 (0) | 2023.03.01 |

| Day 9: Chapter 5-3, MSE를 그대로 쓰면 안 되나? 왜 logistic regression이 더 필요한가? (0) | 2023.02.28 |